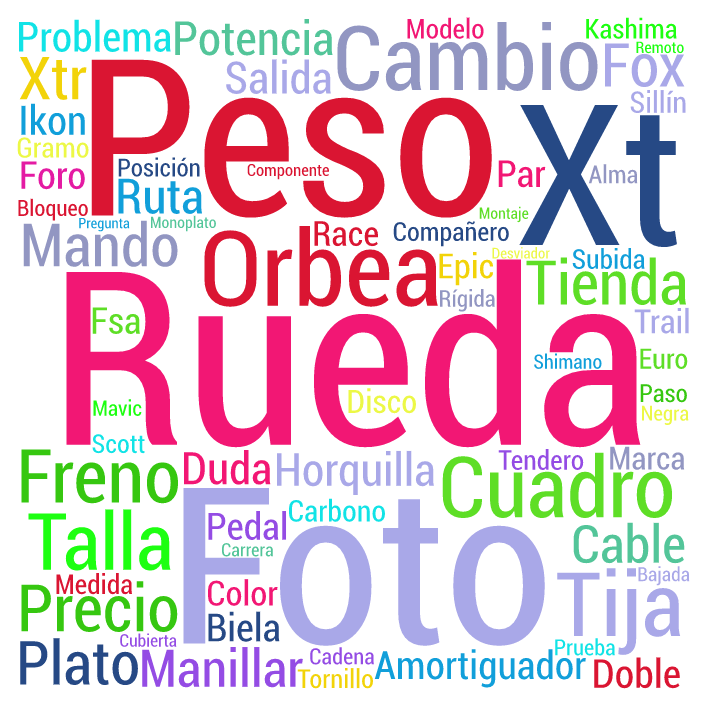

Comentaba en el post anterior que en breve entraremos en la fase de recopilar información de primera mano a través de las entrevistas que mantendremos con profesionales y con miembros del foro de discusión. Así que es fácil anticipar que ahí enfrente se disparará un volumen de texto considerable -una vez transcrito- que será materia prima con la que eche a andar el trabajo de campo. La pregunta es obvia: ¿cómo analizar ese diamante en bruto? Sí o sí, con ayuda de herramientas de análisis masivo de texto, algo de lo que ya hemos hablado por aquí.

En nuestra facultad se utiliza Atlas.ti aunque también debo decir que en la de ingeniería hay un grupo de investigación muy volcado en todas estas herramientas y con una visión quizá más amplia. Porque, claro, bordeando eso que hoy en día se llama Big Data, el «análisis masivo» requiere facultades que mejor las delegamos en software sobre todo en una primera fase. En realidad, no sé muy bien dónde está la frontera entre lo masivo (donde el humano mejor se aparta) y lo que este humilde investigador puede hacer «a mano», valga la expresión.

Ha sido una lástima que en las clases de doctorado no hayamos entrado en este campo del análisis cualitativo a través de herramientas como Atlas.ti, NVivo o MAXQDA, por citar algunas que conozco. Por supuesto que hay muchas más de lo que se ha venido en llamar programas para el análisis cualitativo asistido por computador o, más popularmente, por sus iniciales en inglés: CAQDAS. De hecho en la Wikipedia se ha elaborado una tabla comparativa que evidencia la efervescencia de este tipo de software.

Mirando en esta lista las funcionalidades que los diferentes paquetes aportan, veo que además de los tres que citaba, aparece también RQDA, dentro del paquete R, con licencia open source New BSD. Tendré que enterarme para ver si finalmente: (1) decido usar algún tipo de software de estas características, y (2) uso alguno de ellos porque convenga más a los objetivos de la investigación. Ya tengo trabajo mientras voy preparando el terreno para las entrevistas 🙂

No cabe duda de que en gran parte las personas lo somos en tanto que utilizamos un lenguaje. Las palabras que decimos o que escribimos se convierten en una huella que dice mucho de cada cual. Por supuesto que no solo somos palabra pero es cierto que cuando se puede acceder a grandes volúmenes de lo que una persona dice o escribe, podemos «fotografiar» casi en modo automático a ese ser humano en cuestión. Ya escribimos de ello hace poco. (más…)

No cabe duda de que en gran parte las personas lo somos en tanto que utilizamos un lenguaje. Las palabras que decimos o que escribimos se convierten en una huella que dice mucho de cada cual. Por supuesto que no solo somos palabra pero es cierto que cuando se puede acceder a grandes volúmenes de lo que una persona dice o escribe, podemos «fotografiar» casi en modo automático a ese ser humano en cuestión. Ya escribimos de ello hace poco. (más…)